챗GPT 운영 GPU 1만개 소요

고전력·고비용 문제 해결 필요

삼성전자, 지능형반도체 강점

하이닉스, 고대역메모리 활용

과기부, 3년간 1000억원 지원

14일 업계에 따르면 챗GPT 운영엔 엔비디아의 그래픽처리장치(GPU) ‘A100’ 1만여개가 사용된다. AI 운용에 쓰이는 슈퍼컴퓨터엔 보통 GPU가 몇만 개 단위로 들어간다. GPU 수만 개가 방대한 양의 연산을 빠르게 처리하기 위해서는 고전력, 고비용이 들어갈 수밖에 없다. 샘 올트먼 오픈AI 최고경영자(CEO)는 최근 트위터에 “챗GPT 1회 사용에 몇 센트가 든다”고 적기도 했다. 챗GPT 가입자가 최근 1억명에 도달한 만큼 운영 비용은 하루 수백억원에 달할 것으로 추산된다.

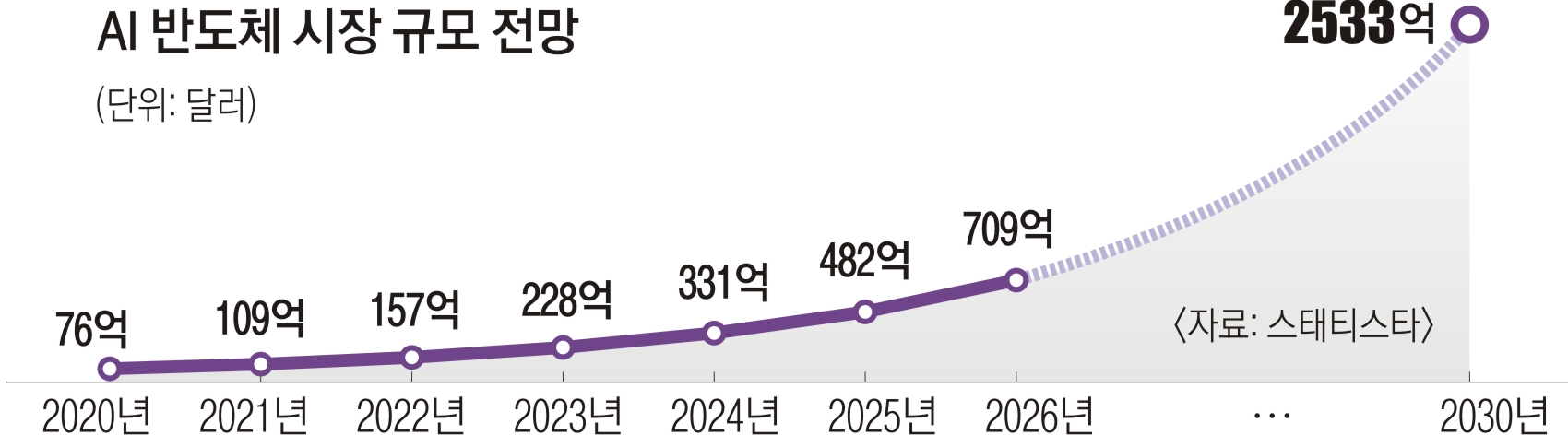

국내 관련 업체들과 정부까지 나서서 AI 전용 반도체 개발을 추진하는 이유가 이런 고전력·고비용 문제에 있다. 앞으로 생성 AI 서비스가 더 많아질 것으로 예상되며, 업계가 저전력·고효율 반도체를 필요로 하기 때문이다.

우선 삼성전자와 SK하이닉스는 GPU에 붙는 메모리반도체 쪽에서 앞서 나가고 있다. 삼성전자는 자체 연산 기능이 탑재된 지능형반도체(PIM) 제품을 GPU 업계 2위인 AMD에 공급하고 있다. PIM은 프로세서와 메모리 사이에 오가는 데이터의 양을 자체 연산 기능으로 조절, 데이터 병목 현상을 해결하고 전력 효율을 크게 높일 수 있다. 삼성전자는 PIM 기술 고도화를 위해 네이버와 협력하고 있다.

SK하이닉스는 업계 1위 엔비디아의 A100과 더 발전한 모델인 ‘H100’ 칩셋에 자사 고대역폭메모리(HBM) 반도체를 공급한다. HBM은 대량의 데이터를 한 번에 보낼 수 있는 메모리로, 지난해부터 AI 서버용으로 적용되기 시작했다. 챗GPT 등장 이후 수요가 예상보다 빠르게 증가하고 있다는 게 업계의 설명이다.

애초 AI 전용으로 만들어진 게 아닌 GPU 이후의 반도체로 신경망처리장치(NPU)가 주목을 받고 있다. 한국전자통신연구원(ETRI)이 2021년 말 자체 개발한 NPU를 서버에 도입해 본 결과 GPU 기반 서버보다 연산 성능은 4배, 전력 효율은 7배 늘었다.

다만 아직까지 AI 개발 환경이 GPU 기반으로 형성돼 NPU 시장은 초기 단계다. 정부는 AI 반도체 부문에 4년간 총 1조 200억원을 투자하겠다고 밝혔다. 과학기술정보통신부는 국산 AI 반도체를 단계별로 데이터센터에 적용해 국내 클라우드에 기반한 AI 서비스를 실증한다는 계획을 세웠다. 여기에만 올해 428억원, 2025년까지 1000억원을 지원한다.

‘AI 컴퍼니’를 비전으로 삼은 SK텔레콤은 자체 개발한 AI 반도체 ‘사피온’ 고도화에 집중하고 있다. KT는 반도체 제조사 리벨리온과 ‘AI 반도체 드림팀’을 구성해 AI 반도체 개발에 나섰다. 리벨리온은 최근 국내 최초로 챗GPT의 원천 기술인 ‘트랜스포머’ 계열 자연어 처리 기술을 지원하는 AI 반도체 ‘아톰’(ATOM)을 출시한다고 밝혔다.

2023-02-15 17면

Copyright ⓒ 서울신문. All rights reserved. 무단 전재-재배포, AI 학습 및 활용 금지