‘AI 고수’ 배재경 업스테이지 테크리더가 말하는 AI의 속내

‘사람 눈에 적합한 문장’ 생성 목표

자의식 있는 듯 착시현상 일으켜

챗GPT 같은 AI, 정보 민주화 도움

정확성·시의성·비용 문제 해결해야

AI 업계 화려한 ‘스펙’을 가진 이들이 모여 있는 스타트업 ‘업스테이지’에서 AI 프로덕트 사업을 총괄하는 배재경(사진) 테크리더는 26일 서울신문과의 인터뷰에서 “영화에 등장하는 무서운 AI를 업계에선 인공일반지능(AGI·인간이 할 수 있는 어떤 지적인 임무도 해내는 단계)이라고 한다”며 “하지만 아직 챗GPT는 모르는 것을 모른다고 하는 능력, 또는 아는 것에 대해 어느 정도 확신하는지를 표현하는 능력조차 많이 부족해, AGI는 먼 얘기”라고 말했다. 다음은 일문일답.

배재경 업스테이지 테크리더

“자의식이 있는 것처럼 보이는 건 일종의 착시다. 생성 모델의 특성상 그럴듯한 문장을 만들어 내는 데는 탁월한 능력이 있다. AI의 학습은 두 가지 형태가 있는데 특정 지식 자체를 학습하기도 하지만 그 지식들 사이의 공통 패턴이나 지식을 표현하는 방법도 학습한다. 챗GPT는 이 중 특히 후자를 좀더 잘하도록 추가 학습이 많이 됐다. 학습의 목표가 정확성보다는 ‘사람이 보기에 적합’이었다.”

-초거대 AI 모델은 뭐고 ‘초’거대가 되려면 어떤 기준을 충족해야 하는 건가. 생성 AI 모델은 또 뭔가. 둘 사이에 어떤 관계가 있나.

“‘초’거대라고 하는 데에 명확한 기준은 없다. 오픈AI의 언어 모델 ‘GPT3’이 시발점으로 보인다. AI는 특정 문제 영역 한 가지를 잘하는 모델에서 최대한 많은 데이터를 학습하고 문제 영역에 특화된 데이터를 활용하는 걸 잘하는 모델로 변화했다. 기존 모델이 그래픽처리장치(GPU)가 4~8장 꽂힌 장비 한 대로 충분했다면 GPT3 이후엔 장비 수백~수천 대 수준이 필요하게 되면서 ‘초거대’라고 부르기 시작했다. 초거대 모델과 생성 모델은 논리적으로는 상관관계가 없지만, 초거대가 아닌 생성 모델은 성능이 안 나오기 때문에 지금처럼 ‘생성’과 ‘초거대’가 같이 쓰이다 보니 혼동이 생기는 것 같다.”

-전문가가 보기에도 챗GPT는 놀라운가. 인터넷, 스마트폰이 나타났을 때와 비슷한 충격인가.

“챗GPT의 등장에 업계도 대체로 놀랍다는 반응이다. 그런데 인터넷, 스마트폰과 비교해야 하는 건 챗GPT가 아니라 AI가 가져올 변화다. 인터넷은 도구가 활성화될 수 있는 기반을 마련했고 스마트폰은 그 토대 위에서 인터넷을 더 활용성 있게 한 하드웨어로서 정보 민주화를 일으켰다. AI는 소프트웨어로서 정보 민주화에 도움을 준다고 보면 될 것 같다.”

-주로 검색 광고를 하는 회사들이 AI 챗봇을 만드는데, 구글이 경계하는 것처럼 챗GPT 등장으로 검색 광고 시장이 변화할 것으로 보는지.

“챗GPT처럼 대화형 검색에서 결과의 주요 문장에 레퍼런스(참고) 링크가 달리는데, 광고주들이 이 레퍼런스를 놓고 경쟁하게 만들 수 있을 것 같다. 예를 들면 돈 많이 낸 사이트 위주로 레퍼런스를 연결해 준다든지. 더 중요한 변화는 ‘구독형’으로 지식 소비 형태가 전환되는 것이다. 유튜브 때문에 검색 엔진을 덜 활용하게 됐고, 챗GPT도 이달 초 월 20달러짜리 구독형 서비스를 출시했다.”

-AI 챗봇이 넘어야 할 문제는.

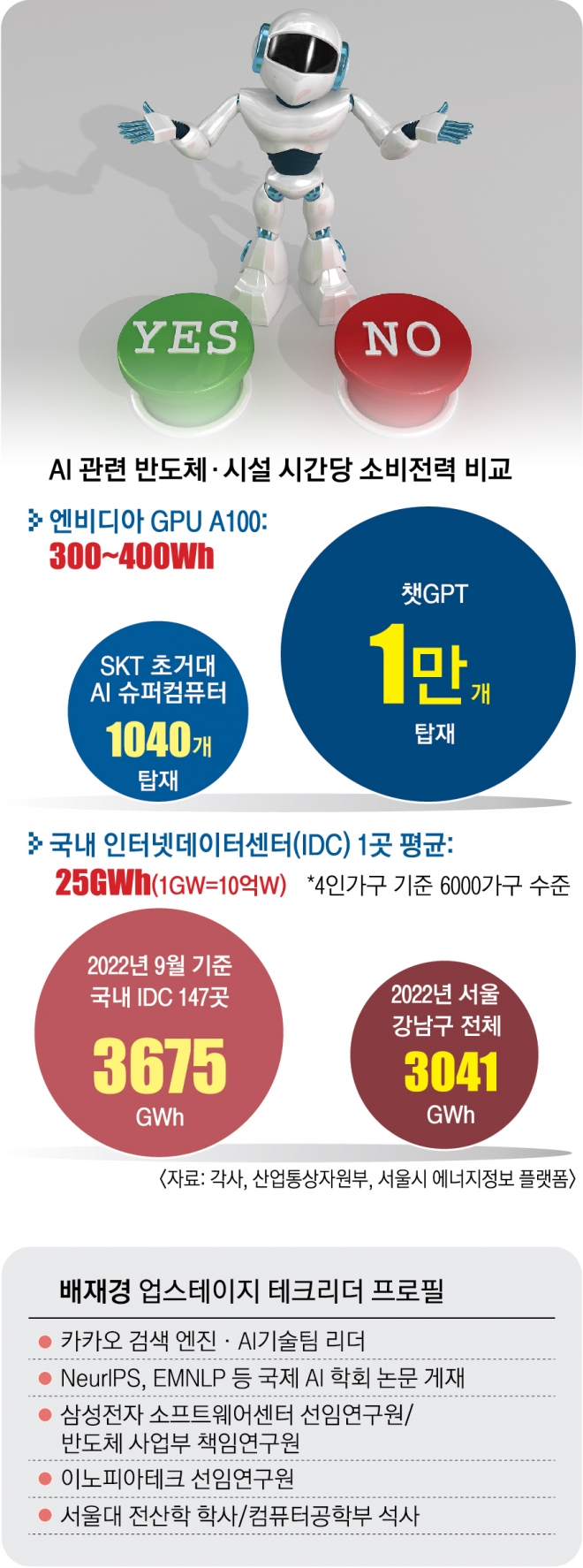

“첫 번째는 정확성 문제다. 모르는 걸 모른다고 할 수 있어야 사람이 신뢰할 수 있다. 점진적으로 발전해 쓸 만한 수준은 될 것이지만, 여전히 사실 여부에 대한 최종 판단은 사람의 몫이 될 것이다. 두 번째는 시의성 문제다. 학습하는 데에 오래 걸려서 최신 정보를 학습하고 서비스에 반영하는 게 느릴 수밖에 없다. 서버 성능이 좋아지고 학습 방식이 개선되면 점점 나아질 문제다. 세 번째는 비용이다. 학습 비용뿐 아니라 서비스 중에도 계속 GPU 장비를 엄청나게 사용해야 한다. 인프라 비용이 천문학적일 수밖에 없다. 지금 오픈AI가 운영하는 구독 서비스도 얼마나 수지타산이 맞을지 의문이다.”

2023-02-27 2면

Copyright ⓒ 서울신문 All rights reserved. 무단 전재-재배포, AI 학습 및 활용 금지